Le déploiement rapide des infrastructures cloud a fondamentalement changé la manière dont les entreprises conçoivent et gèrent leurs ressources informatiques. À mesure que les organisations adoptent des stratégies multi-cloud et des déploiements hybrides complexes, les défis liés à la sécurité, à la conformité et à l’excellence opérationnelle ont augmenté de manière exponentielle. Chez ICT.technology, nous avons constaté qu’une adoption réussie du cloud et l’exploitation des centres de données nécessitent bien plus qu’une simple expertise technique – ils exigent une approche systématique du déploiement des infrastructures qui aborde ces défis de manière ciblée. Certaines entreprises ont déjà appris cette leçon à leurs dépens.

Comment sept serveurs ont fait chuter un géant de Wall Street

Le 31 juillet 2012, Knight Capital Group était à son apogée. En tant que l’une des plus grandes firmes de trading de Wall Street, elle contrôlait 17,3 % du volume des transactions du NYSE et 16,9 % des transactions du NASDAQ, traitant près de 4 milliards d’actions chaque jour. Sa réputation venait tout juste d’être renforcée par une distinction de Wall Street Letter pour ses algorithmes Knight Direct et sa plateforme de trading Hotspot FX. La vie était belle.

Le 31 juillet 2012, Knight Capital Group était à son apogée. En tant que l’une des plus grandes firmes de trading de Wall Street, elle contrôlait 17,3 % du volume des transactions du NYSE et 16,9 % des transactions du NASDAQ, traitant près de 4 milliards d’actions chaque jour. Sa réputation venait tout juste d’être renforcée par une distinction de Wall Street Letter pour ses algorithmes Knight Direct et sa plateforme de trading Hotspot FX. La vie était belle.

Puis vint la matinée du 1ᵉʳ août 2012. Ce qui avait commencé comme un déploiement logiciel de routine sur huit serveurs s’est transformé en l’un des épisodes les plus coûteux de l’histoire de la finance, en seulement 45 minutes. Le problème ne venait pas du nouveau code en lui-même, mais de la manière dont il interagissait avec une ancienne fonctionnalité désactivée encore présente sur certains serveurs – une bombe à retardement numérique qui n’attendait qu’à exploser.

Avant le 1ᵉʳ août, Knight Capital disposait d’un ancien code appelé "Power Peg", qui avait été désactivé. Ce code n’était plus utilisé. Bien que désactivé via un indicateur, le code sous-jacent était toujours présent – et gravement défectueux.

Un nouveau déploiement des serveurs avait été planifié, avec une fenêtre de maintenance au milieu de la nuit afin d’éviter toute perturbation pendant les heures de trading.

Le 31 juillet 2012, l’entreprise a commencé le déploiement du nouveau logiciel de trading sur huit serveurs. Cependant, le déploiement fut incohérent :

- Sur sept serveurs, le nouveau code a été correctement déployé.

- Sur un serveur, le nouveau logiciel n’a pas été déployé, il a été oublié.

- La mise à jour logicielle a réactivé par erreur l’ancien indicateur Power Peg.

En conséquence, certains serveurs fonctionnaient avec le nouveau code, tandis qu’un autre utilisait encore l’ancien. Ce serveur avec l’ancien code traitait toujours des données de test – mais générait des ordres de trading réels.

À l’ouverture du marché, le chaos s’est déclenché.

Les systèmes de trading de Knight Capital se sont emballés, exécutant des transactions erronées à une vitesse vertigineuse. En seulement 45 minutes, leur système de trading automatisé a déclenché plus de 4 millions de transactions involontaires.

Le résultat ? Une perte stupéfiante de 460 millions de dollars, comme l’ont rapporté Business Insider et Bloomberg. L’action de Knight Capital a chuté de 32,8 % en une seule journée.

Les conséquences furent brutales. Pour éviter la faillite, l’entreprise a dû recevoir une injection d’urgence de 400 millions de dollars. Le 15 octobre 2013, la SEC a conclu son enquête avec une amende de 12 millions de dollars pour violation des réglementations de trading, en raison de l’absence de mesures de sécurité adéquates.

Ironiquement, cette catastrophe aurait pu être évitée grâce à une automatisation correcte de l’infrastructure et à de bonnes pratiques de déploiement. Des configurations de serveurs manuelles, des déploiements incohérents et l’absence d’environnements de test appropriés ont créé la tempête parfaite. Sept serveurs – c’est tout ce qu’il a fallu pour faire tomber une entreprise qui traitait près de 4 milliards d’actions par jour.

Cet incident est un rappel saisissant de la raison pour laquelle des outils modernes de provisionnement d’infrastructure comme Terraform existent. Lorsqu’une simple configuration incohérente sur une poignée de serveurs peut coûter près d’un demi-milliard de dollars, les anciennes méthodes de gestion manuelle de l’infrastructure et l’espoir que tout se passe bien ne suffisent tout simplement plus.

La catastrophe de Knight Capital n’était pas seulement une erreur logicielle – c’était un échec du management de l’infrastructure. Aujourd’hui, où l’infrastructure peut être définie en tant que code, versionnée et déployée automatiquement avec des configurations cohérentes, une telle catastrophe serait beaucoup plus difficile à reproduire. Bien que, si l’on doit échouer, le faire d’une manière aussi spectaculaire qu’on en parle dans toutes les présentations DevOps pendant une décennie et demie, est aussi une forme de réussite.

Passons maintenant à la manière dont la provision d’infrastructure moderne peut prévenir de telles catastrophes...

L'évolution du provisionnement de l'infrastructure

Le provisionnement moderne de l'infrastructure doit également répondre à la réalité des environnements hybrides et multi-cloud. Les organisations utilisent souvent plusieurs fournisseurs de cloud en complément des centres de données sur site pour répondre à des exigences spécifiques ou se conformer aux réglementations locales. Terraform offre dans ces scénarios une approche unifiée pour la gestion des ressources à travers différents fournisseurs. Cette capacité est particulièrement précieuse lorsque les organisations souhaitent maintenir la cohérence de leur approche infrastructurelle tout en exploitant les fonctionnalités spécifiques des fournisseurs.

Les possibilités d'intégration de Terraform vont au-delà des infrastructures cloud. Les entreprises modernes ont besoin d'outils d'infrastructure qui s'intègrent de manière transparente aux systèmes existants de surveillance, de journalisation et de sécurité. L'écosystème des providers Terraform permet aux entreprises de gérer ces intégrations sous forme de code et de s'assurer que toute nouvelle infrastructure est équipée dès le départ des politiques de sécurité et de surveillance appropriées.

Les avantages de l'Infrastructure-as-Code déclarative

Le passage des configurations manuelles au déploiement automatisé de l'infrastructure marque une évolution significative. Cependant, toutes les approches d'automatisation ne se valent pas. Examinons de plus près la différence entre les modèles de déploiement impératif et déclaratif.

L'incident de Knight Capital a mis en évidence les risques d'une gestion impérative et progressive de l'infrastructure. L'approche déclarative de Terraform repose sur un paradigme fondamentalement différent. Plutôt que de définir des chaînes de commandes détaillées, les organisations décrivent l'état final souhaité. Ce changement permet aux ingénieurs de se concentrer sur l'objectif à atteindre plutôt que sur la liste précise des commandes nécessaires.

Le modèle déclaratif permet à Terraform de gérer automatiquement les dépendances complexes, garantissant ainsi que les ressources sont créées dans le bon ordre et que les relations entre les différentes composantes sont préservées. Cette approche systématique contribue à éviter les déploiements incohérents susceptibles de provoquer des incidents comme celui de Knight Capital.

| Impératif (Exemples : Scripts Bash, Rôles Ansible) | Déclaratif (Exemples : SQL, Manifests Terraform) |

|---|---|

| Définit des instructions étape par étape pour atteindre le résultat souhaité. | Définit l'état final souhaité—le système détermine automatiquement les étapes nécessaires. |

| L'exécution est séquentielle. Les commandes doivent être exécutées dans un ordre précis. Les dépendances doivent être gérées manuellement. | L'exécution est pilotée par l'état—Terraform calcule les dépendances et l'ordre d'exécution. |

| Des interventions manuelles sont souvent nécessaires pour la gestion du cycle de vie des ressources. | Gestion automatisée des ressources (création, mise à jour, suppression). |

| Typiquement sans état & non idempotent, ce qui signifie que l'exécution répétée peut entraîner des modifications involontaires. | Avec état & idempotent, garantissant des résultats cohérents lors d'exécutions répétées. |

| Accent sur le contrôle du processus : Vous définissez comment les ressources sont configurées. | Accent sur le résultat : Vous définissez à quoi doit ressembler l'infrastructure finale. |

Modules Terraform : Code réutilisable pour toute l'organisation

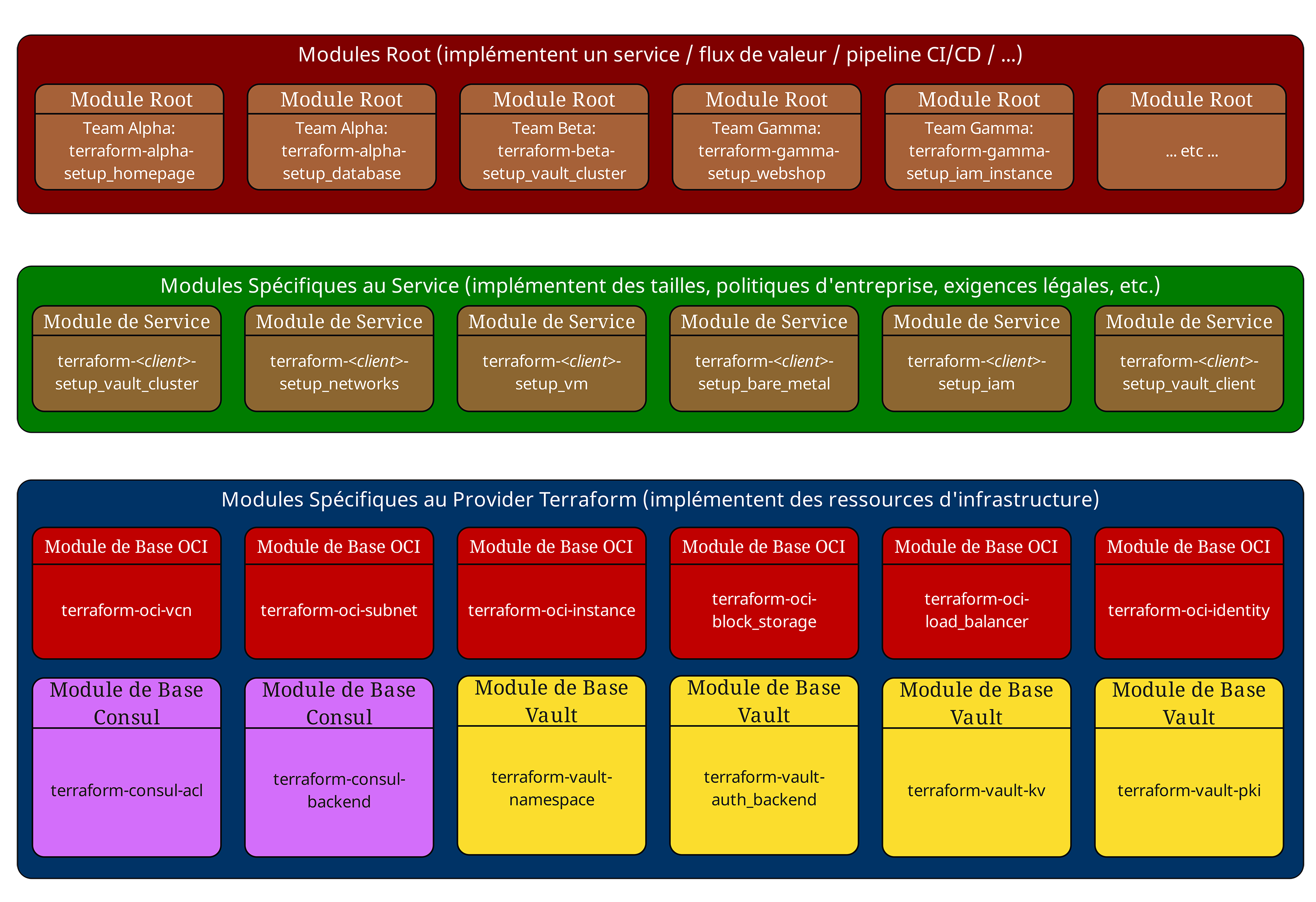

La gestion des ressources et les capacités de mise à l'échelle sont un autre aspect crucial du déploiement moderne de l'infrastructure. Le système de modules de Terraform nous permet de créer des composants réutilisables pour nos clients, intégrant les bonnes pratiques, les contrôles de sécurité pendant la phase de planification et d'exécution, ainsi que des politiques commerciales spécifiques. Ces modules peuvent être partagés entre les équipes afin d'assurer une implémentation cohérente des modèles d'infrastructure, tout en permettant une certaine flexibilité d'adaptation. Cette approche réduit considérablement le temps nécessaire au déploiement de nouveaux environnements tout en garantissant les plus hauts standards en matière de sécurité et de conformité.

Architecture indépendante du cloud

Examinons un scénario d'entreprise typique où une application nécessite des Load Balancers, des machines virtuelles, des composants réseau et des règles de pare-feu sur plusieurs fournisseurs de cloud. Avec les approches traditionnelles, le déploiement de cette infrastructure exige une expertise approfondie des outils et interfaces propres à chaque fournisseur. Terraform propose une syntaxe cohérente et un workflow unifié via HCL2 (HashiCorp Configuration Language 2.0), mais le code sous-jacent, dépendant du fournisseur, reste fondamentalement différent. Par exemple, la configuration d'un Load Balancer pour AWS nécessitera des définitions et attributs de ressources totalement distincts de ceux d'Oracle Cloud Infrastructure (OCI), d'Azure ou d'autres fournisseurs de cloud.

Alors que les supports marketing de HashiCorp suggèrent une expérience multi-cloud transparente, chaque fournisseur impose en réalité une implémentation spécifique, des compétences dédiées et une gestion continue des modules interagissant avec ses API. Grâce à une abstraction bien pensée et un système de modules performant, les organisations peuvent concevoir des interfaces structurées offrant aux utilisateurs finaux une expérience cohérente pour le déploiement et la gestion des ressources sur différents fournisseurs de cloud.

Chez ICT.technology, nous mettons en œuvre cette abstraction grâce à une architecture modulaire en deux couches bien définies. La base repose sur des "Modules de base" – des modules dépendants des fournisseurs, qui intègrent les exigences spécifiques de chaque plateforme cloud et interagissent directement avec les API des providers correspondants. Ces modules de base doivent être maintenus activement et adaptés aux nouvelles fonctionnalités des fournisseurs.

Au-dessus de cette couche, nous avons les "Modules de service", qui implémentent les services métier, les politiques de conformité et des configurations standardisées (par ex. tailles prédéfinies). Le principe architectural central est que les modules de service ne doivent jamais interagir directement avec les providers Terraform – ils appellent exclusivement les modules de base. Cette séparation claire des responsabilités garantit une véritable abstraction. Sur ces modules spécifiques aux providers, les organisations peuvent développer des couches d'abstraction supplémentaires qui offrent aux utilisateurs finaux une interface unifiée. Lorsqu'il est soigneusement mis en œuvre, ce concept permet de déployer des ressources avec un code cohérent et indépendant des fournisseurs dans divers environnements – toutefois, cette capacité doit être développée et entretenue activement, car elle ne constitue pas une fonctionnalité native de Terraform.

Gestion du State

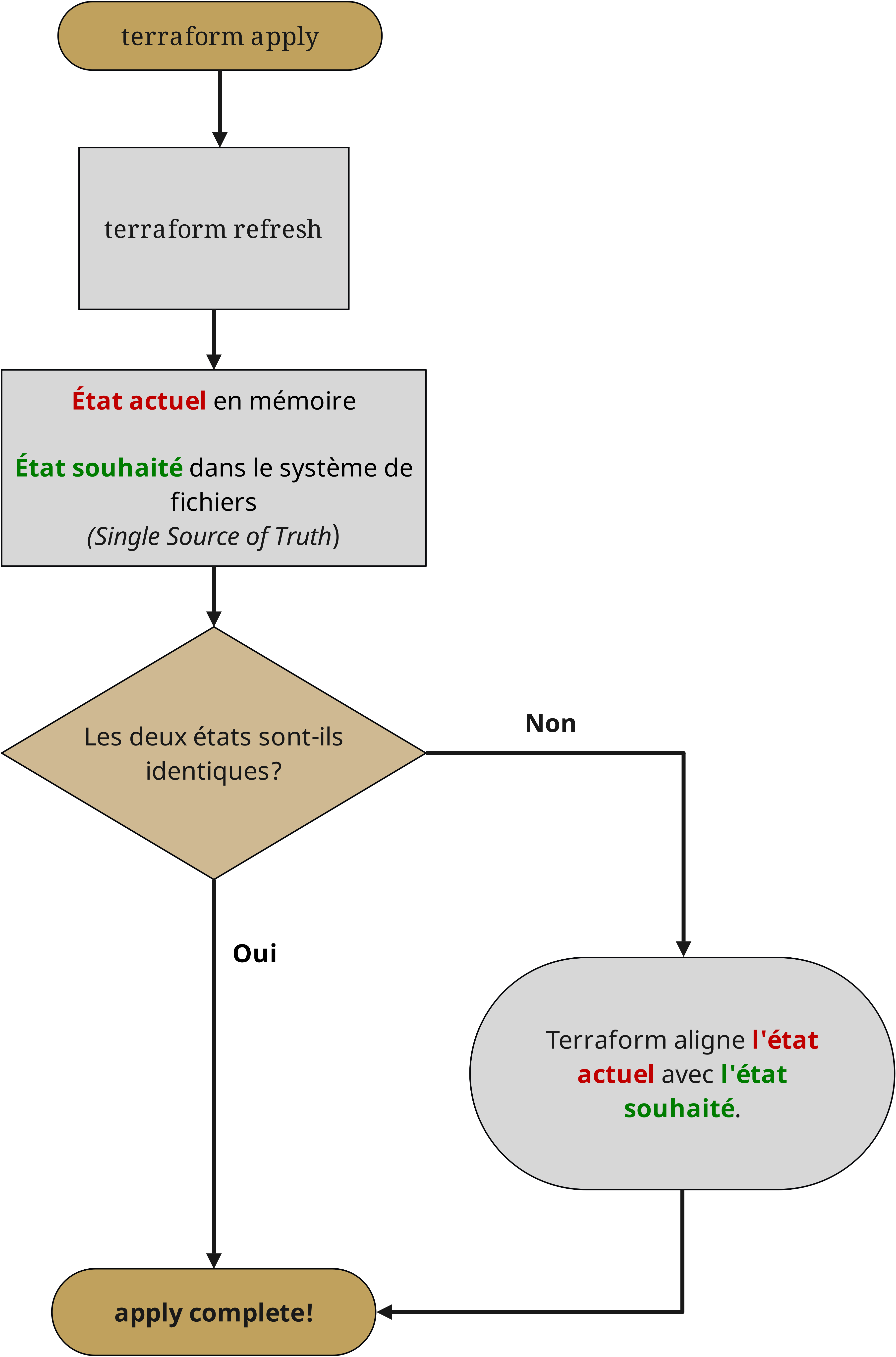

La puissance de Terraform se manifeste particulièrement dans ses capacités de gestion de l'état. Les fichiers d'état servent de "source unique de vérité" (Single Source of Truth) pour l'infrastructure, en suivant toutes les ressources et leurs relations. Tant la version libre de HashiCorp Terraform que Terraform Enterprise prennent en charge la gestion du State à distance via différents backends, avec des différences en termes d'effort d'implémentation et de responsabilité opérationnelle.

HashiCorp Terraform offre une prise en charge intégrée des States distants via la source de données terraform_remote_state et permet, avec des backends supportés comme Consul, de verrouiller le State pour un travail collaboratif. De plus, des solutions de stockage comme Amazon S3 peuvent être utilisées, bien qu'elles ne soient pas officiellement supportées par HashiCorp. La différence clé réside dans l'effort d'implémentation et la responsabilité opérationnelle : avec la version libre de HashiCorp Terraform, les organisations doivent mettre en place et gérer leur propre infrastructure de gestion du State, y compris les procédures de sauvegarde, la gestion des dépendances et la protection des fichiers State contre les erreurs. Terraform Enterprise, en revanche, offre ces fonctionnalités sous forme de service managé, avec des contrôles de sécurité intégrés, des politiques de conformité et une journalisation détaillée des audits.

Marges d'amélioration : Stratégies de déploiement

Bien que Terraform excelle dans le déploiement d'infrastructure, les organisations ont souvent besoin de stratégies de déploiement plus avancées telles que les déploiements Blue-Green ou les Canary Releases. Ces modèles nécessitent généralement des outils supplémentaires et une orchestration au-delà des fonctionnalités natives de Terraform. Lorsqu'une ressource doit être recréée, le comportement par défaut de Terraform consiste à détruire la ressource existante avant d'implémenter la nouvelle version, ce qui peut entraîner des interruptions de service.

Les organisations associent souvent Terraform à des outils complémentaires comme HashiCorp Consul, HashiCorp Nomad et des plateformes de déploiement applicatif pour mettre en œuvre des modèles de déploiement plus complexes. Grâce à une gestion rigoureuse du State et à une versionnage de l'infrastructure, Terraform gère les composants d'infrastructure, tandis que d'autres outils prennent en charge le routage du trafic et la livraison des applications.

Gestion des risques critiques dans l'infrastructure cloud

À mesure que les organisations étendent leur infrastructure cloud, elles sont confrontées à plusieurs risques critiques qui doivent être soigneusement gérés. Comprendre ces risques et mettre en place des contrôles appropriés tout au long du cycle de déploiement de l'infrastructure est essentiel pour garantir un environnement sécurisé et conforme.

Sécurisation de l'infrastructure cloud par le code

Les failles de sécurité dans l'infrastructure cloud résultent souvent d'une mise en œuvre incohérente des contrôles de sécurité et d'un manque de standardisation entre les différents environnements. Les approches de sécurité traditionnelles, qui reposent fortement sur des configurations manuelles et des audits ponctuels, ont du mal à suivre le rythme des évolutions rapides des environnements cloud.

Les failles de sécurité dans l'infrastructure cloud résultent souvent d'une mise en œuvre incohérente des contrôles de sécurité et d'un manque de standardisation entre les différents environnements. Les approches de sécurité traditionnelles, qui reposent fortement sur des configurations manuelles et des audits ponctuels, ont du mal à suivre le rythme des évolutions rapides des environnements cloud.

Terraform constitue une base robuste pour l'adoption des pratiques de Security-as-Code grâce à son intégration étroite avec l'écosystème HashiCorp et d'autres solutions de sécurité d'entreprise. HashiCorp Vault agit comme une plateforme centrale de gestion des secrets et de protection des données, pouvant être configurée et utilisée directement via Terraform.

Grâce à Terraform, les organisations peuvent automatiser la configuration des Secret Engines de Vault, des méthodes d'authentification et des politiques de contrôle d'accès. Cela permet :

- la gestion automatisée des secrets,

- le chiffrement,

- et les contrôles d'accès basés sur l'identité

sur l’ensemble de l’infrastructure. Par exemple, Terraform peut configurer Vault pour gérer dynamiquement les mots de passe des bases de données, s'intégrer aux services de gestion des clés des fournisseurs de cloud, administrer des infrastructures PKI et exiger une authentification multi-facteurs (MFA) avant d’autoriser toute modification de l’infrastructure – le tout sans stocker de données sensibles dans le code Terraform.

La gestion des identités et des accès est une composante essentielle de la sécurité de l'infrastructure. Les organisations utilisent souvent Keycloak comme fournisseur d'identité, entièrement géré via Terraform. Cela inclut l'automatisation de la création des Realms, des Clients, des Rôles et des Groupes, ainsi que la configuration de la fédération avec les systèmes d'identité d'entreprise.

Terraform peut également gérer l'intégration entre Keycloak et d'autres outils de sécurité comme Vault, afin de créer un cadre cohérent de gestion des identités et des accès. HashiCorp Boundary peut fournir un contrôle d'accès supplémentaire basé sur l'identité et des fonctionnalités d'audit SSH, mais chez ICT.technology, nous ne considérons pas Boundary comme prêt pour la production, sauf si une entreprise dispose déjà d’un cluster PostgreSQL hautement sécurisé et hautement disponible dans son Trust Center. PostgreSQL est une exigence incontournable pour HashiCorp Boundary au moment de la rédaction de cet article, ce qui en fait une option difficilement réalisable dans les environnements d’entreprise ayant des exigences de sécurité strictes, des contraintes de chaîne d’approvisionnement et la nécessité d’un support éditeur.

La mise en œuvre pratique des contrôles de sécurité dans Terraform nécessite une approche outillée complète. Les hooks Pre-Commit dans les systèmes de contrôle de version permettent d’effectuer des validations de sécurité avant même le commit. Des outils d'analyse statique intégrés dans les pipelines CI/CD peuvent inspecter les configurations Terraform pour détecter des erreurs de sécurité, des expositions potentielles de données et des violations de conformité. Des outils comme checkov offrent des analyses automatisées de sécurité et de conformité spécifiques à Terraform.

Ces outils peuvent être configurés pour appliquer des politiques de sécurité spécifiques à l’entreprise et fournir des analyses de sécurité pendant le processus de déploiement de l’infrastructure. Pour l’analyse statique du code et les vérifications de sécurité, les organisations utilisent souvent des outils comme tfsec pour l’analyse des meilleures pratiques de sécurité et HashiCorp Sentinel pour l’application des règles de Policy-as-Code et la validation de la conformité. Bien que Terraform ne fournisse pas directement de systèmes de surveillance de la sécurité, il permet de configurer l'infrastructure et les intégrations nécessaires aux outils de sécurité. Par exemple, Terraform peut configurer la redirection des logs vers des systèmes SIEM tels que Splunk ou la suite ELK, définir les configurations réseau requises et gérer les autorisations d’accès.

La surveillance de la sécurité en temps réel dans les environnements d'entreprise nécessite une intégration soignée entre le déploiement de l’infrastructure et les systèmes de sécurité. Terraform peut configurer des solutions de monitoring d’entreprise via des providers officiels, tels que Datadog pour l’analyse de l’infrastructure et Palo Alto Prisma Cloud pour la sécurité cloud. Le provider ServiceNow permet d’intégrer des fonctionnalités basiques de gestion des configurations, bien que les intégrations complexes au sein des grandes entreprises nécessitent souvent des outils d’orchestration supplémentaires.

Les outils de sécurité automatisés jouent un rôle essentiel dans le maintien de la conformité continue et d’une stratégie de cybersécurité robuste. Les outils de validation de configuration peuvent appliquer des normes de sécurité personnalisées dès la phase de planification Terraform. Les outils de scan de secrets s’intègrent aux systèmes de contrôle de version pour éviter les commits accidentels de données sensibles. Les frameworks de Policy-as-Code permettent aux organisations de définir et d'appliquer des politiques de sécurité de manière cohérente sur toutes les infrastructures déployées. Ces outils travaillent de concert pour créer un pipeline d'automatisation de la sécurité complet, qui vérifie les modifications de l'infrastructure à plusieurs étapes – du développement initial jusqu’au déploiement en production.

Éviter les dérives de configuration (Drift) et les erreurs de configuration

Les dérives de configuration représentent l'un des plus grands risques opérationnels dans les environnements cloud. À mesure que les systèmes évoluent et que les équipes apportent des modifications, il devient de plus en plus difficile de maintenir la cohérence entre l'état souhaité et l'état réel de l'infrastructure. Les erreurs de configuration peuvent entraîner des failles de sécurité, des violations de conformité et des problèmes opérationnels.

Les dérives de configuration représentent l'un des plus grands risques opérationnels dans les environnements cloud. À mesure que les systèmes évoluent et que les équipes apportent des modifications, il devient de plus en plus difficile de maintenir la cohérence entre l'état souhaité et l'état réel de l'infrastructure. Les erreurs de configuration peuvent entraîner des failles de sécurité, des violations de conformité et des problèmes opérationnels.

L’approche pilotée par l’état de Terraform fournit une solution puissante pour détecter et corriger ces dérives. En enregistrant continuellement l’état souhaité de l’infrastructure et en le comparant régulièrement à l’état réel, Terraform peut identifier et corriger automatiquement les écarts. Cette fonctionnalité s’étend au-delà des configurations de base des ressources et inclut également les paramètres de sécurité, les balises et autres métadonnées essentielles à la gouvernance.

Les dérives de configuration peuvent être détectées grâce à des opérations Terraform plan régulières, qui comparent l’état actuel avec la configuration souhaitée. Alors que HashiCorp Terraform nécessite une exécution manuelle de ces opérations et une automatisation supplémentaire via des scripts, Terraform Enterprise offre des fonctionnalités intégrées de détection et de correction automatisée des écarts (Drift Detection). Les organisations utilisant la version libre de HashiCorp Terraform développent généralement leurs propres solutions d’automatisation, en planifiant des opérations de planification régulières dans leurs pipelines CI/CD et leurs scripts personnalisés. Cela peut inclure l'exécution programmée des opérations de planification ainsi que des systèmes de notification pour alerter les équipes en cas d'écarts détectés. Cependant, la correction effective des écarts nécessite toujours une évaluation minutieuse des impacts opérationnels et, dans certains cas critiques, une validation humaine avant l’application des modifications.

La gestion sécurisée des fichiers State de Terraform constitue un autre aspect crucial de la chaîne de sécurité. Les organisations utilisant la version libre de Terraform s’appuient souvent sur un backend sécurisé HashiCorp Consul pour stocker leurs fichiers d’état, tandis que cette fonctionnalité est directement intégrée dans Terraform Enterprise. Les systèmes de contrôle de version suivent les modifications des définitions d’infrastructure, tandis que des outils d’audit indépendants enregistrent en détail toutes les modifications de l’infrastructure. Des outils comme GitLab CI ou Jenkins peuvent être configurés pour imposer des workflows d’approbation des modifications d’infrastructure et garantir que des contrôles de sécurité sont effectués avant leur application.

Assurer une haute disponibilité et minimiser les temps d'arrêt

Les interruptions de service et les temps d’arrêt peuvent avoir un impact significatif sur les opérations commerciales et la satisfaction des clients. Le déploiement moderne de l’infrastructure doit inclure des stratégies robustes pour assurer une disponibilité continue tout en permettant des mises à jour et des modifications nécessaires.

La gestion avancée de l’état et le suivi des dépendances dans Terraform permettent aux organisations de mettre en œuvre des stratégies de déploiement complexes minimisant les interruptions. Les déploiements Blue-Green peuvent, par exemple, être orchestrés via Terraform en créant une nouvelle infrastructure en parallèle de l’environnement existant, en la validant, puis en dirigeant progressivement le trafic via des Load Balancers. Une fois la transition effectuée et stabilisée, Terraform peut désactiver les ressources inutilisées afin de réduire les coûts.

La capacité de la plateforme à gérer des dépendances complexes garantit que les ressources sont créées et mises à jour dans le bon ordre, réduisant ainsi le risque d’interruptions de service lors des modifications. Les organisations peuvent implémenter des validations de saisie utilisateur, effectuer des contrôles en temps réel sur les valeurs générées dynamiquement et intégrer des tests automatisés via le Terraform Testing Framework dans leur processus de déploiement d’infrastructure. Cela permet d’identifier les problèmes potentiels dès les premières phases du cycle de développement, avant qu’ils n’affectent les environnements de production.

Respect continu des exigences de conformité

Les exigences de conformité évoluent continuellement et deviennent de plus en plus complexes, en particulier pour les entreprises opérant dans des secteurs réglementés ou sur plusieurs juridictions. Les approches de conformité traditionnelles, reposant sur des audits périodiques et des contrôles manuels, ne suffisent plus à garantir le respect des réglementations dans les environnements cloud modernes.

Terraform permet aux organisations d’implémenter des pratiques de Compliance-as-Code en traduisant les exigences de conformité en définitions d’infrastructure pouvant être gérées sous contrôle de version. Cependant, l’approche d’implémentation diffère considérablement entre la version libre HashiCorp Terraform et sa variante Enterprise. Avec HashiCorp Terraform, les organisations s’appuient généralement sur une combinaison de modules soigneusement élaborés, de règles de validation personnalisées dans les définitions de variables et d’outils externes pour l’application des politiques. Cela peut inclure l’utilisation de hooks Pre-Commit, de scripts de validation personnalisés et de vérifications dans les pipelines CI/CD afin d’assurer la conformité.

Terraform Enterprise intègre la fonctionnalité Policy-as-Code via Sentinel, permettant des contrôles avancés de conformité avant l’application des modifications. Sans la version Enterprise, les entreprises utilisent souvent des solutions alternatives comme Open Policy Agent (OPA), des scripts personnalisés ou des validations intégrées aux pipelines CI/CD. Ces outils externes peuvent appliquer des exigences telles que les conventions de nommage des ressources, les configurations de sécurité et les règles de gouvernance des données, mais nécessitent un effort supplémentaire de mise en place et de maintenance, et restent moins puissants que l’approche intégrée de Terraform Enterprise.

Les fonctionnalités d’audit avancées de la plateforme Terraform Enterprise fournissent des enregistrements détaillés de toutes les modifications d’infrastructure, y compris :

- qui a effectué la modification,

- quand elle a été réalisée, et

- quelles modifications spécifiques ont été appliquées.

Ce journal d’audit est un atout essentiel pour démontrer la conformité lors des inspections et enquêter sur les incidents de sécurité.

Perspectives

À mesure que l’infrastructure cloud évolue, le rôle du déploiement d’infrastructure devient de plus en plus central pour garantir la sécurité, la conformité et l’excellence opérationnelle. Les organisations doivent adopter des approches avancées capables de gérer la complexité des environnements cloud modernes tout en assurant des contrôles de sécurité et de conformité cohérents.

À mesure que l’infrastructure cloud évolue, le rôle du déploiement d’infrastructure devient de plus en plus central pour garantir la sécurité, la conformité et l’excellence opérationnelle. Les organisations doivent adopter des approches avancées capables de gérer la complexité des environnements cloud modernes tout en assurant des contrôles de sécurité et de conformité cohérents.

Le modèle déclaratif de Terraform, combiné à sa gestion avancée de l’état et à son vaste écosystème de providers, constitue une base robuste pour relever ces défis. En mettant en œuvre des pratiques d’Infrastructure-as-Code et en exploitant les fonctionnalités avancées de sécurité et de conformité, les entreprises peuvent construire une infrastructure cloud résiliente, répondant à leurs besoins métier tout en maintenant des standards élevés en matière de sécurité et de conformité.

L’avenir du déploiement d’infrastructure s’orientera sans doute encore davantage vers l’automatisation de la sécurité, l’automatisation de la conformité et l’orchestration intelligente. Les entreprises qui investissent dès aujourd’hui dans des capacités robustes de déploiement d’infrastructure seront bien préparées pour s’adapter à ces exigences en constante évolution, tout en conservant l’agilité nécessaire pour rester compétitives sur des marchés en rapide mutation.