Retrieval-Augmented Generation (RAG) stellt eine bedeutende Weiterentwicklung in der Architektur von Large Language Models (LLM) dar, indem es die Stärke von parametrischen und nicht-parametrischen Speichersystemen kombiniert. Im Kern adressiert RAG eine der grundlegenden Einschränkungen traditioneller LLMs: ihre Abhängigkeit von statischem, vortrainiertem Wissen, das veralten oder spezifischen Kontext fehlen kann, der für präzise Antworten erforderlich ist. Das RAG-Framework ist ein großer Fortschritt auf dem Weg zur Schaffung von Sprachmodellen. Durch die Integration von Retrieval-, Ranking- und Generierungstechniken eröffnet RAG neue Möglichkeiten für KI-Systeme, die wirklich wissensbasierte, kontextbewusste Kommunikation ermöglichen.

Dies ist Teil 1 einer mehrteiligen Serie, in der wir uns mit RAG, seiner Anwendung und Funktionsweise beschäftigen.

Die ursprüngliche wissenschaftliche Arbeit wurde im Mai 2020 von Patrick Lewis und seinen Kollegen unter dem Titel Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks veröffentlicht. Patrick Lewis ist ein in London ansässiger Forschungswissenschaftler im Bereich Natural Language Processing, der bei co:here arbeitet. Die Unternehmenssprachmodelle von co:here bieten wir bei *ICT.technology* unseren Kunden zusätzlich zu den Open-Source-LLama-Modellen an. Wenn Sie an den technischen Details dieser wichtigen Forschung interessiert sind, können Sie hier eine Kopie der überarbeiteten Version von 2021 herunterladen.

Teil 1: Die Grundlagen von Retrieval-Augmented Generation (RAG)

Stellen Sie sich eine riesige Bibliothek vor, in der künstliche Intelligenz sowohl als Bibliothekar als auch als Forscher agiert. Genau das macht Retrieval-Augmented Generation (RAG): Es verwandelt eine KI von einem System, das nur auswendig gelerntes Wissen rezitieren kann, in ein System, das aktiv Informationen durchsucht, bewertet und aus einer dynamischen Wissensbasis nutzt.

Sehen wir uns an, wie dieses digitale Bibliothekssystem funktioniert.

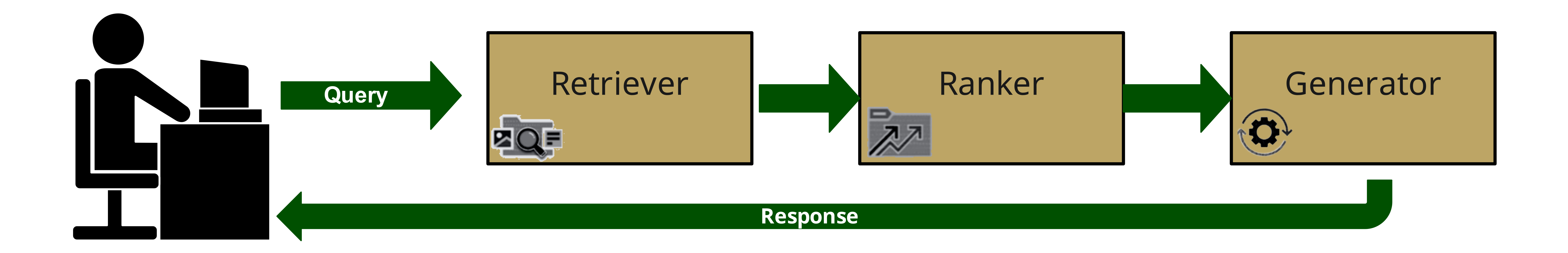

Wie RAG funktioniert: Eine Übersicht auf hoher Ebene

In einer traditionellen Bibliothek gibt es Bibliothekare, die wissen, wie man Informationen findet, Forschungsassistenten, die Quellen bewerten, und Experten, die bei der Interpretation der Ergebnisse helfen. Sie arbeiten mit Büchern, deren Inhalt statisch ist und sich nie ändert. Neue Bücher können hinzukommen, aber die meisten sind alt.

RAG hingegen verfügt über einen brillanten Bibliothekar und Forscher, der sich nicht nur auf auswendig gelerntes Wissen (wie die Bücher der Bibliothek) verlässt, sondern sofortigen Zugriff auf ein riesiges, ständig aktualisierbares Referenzsystem hat. Im Gegensatz zu unserem traditionellen Bibliotheksvergleich basiert dieses System jedoch auf ausgeklügelten mathematischen Prinzipien und neuronalen Architekturen.

Das Personal der digitalen Bibliothek

Die Raffinesse des RAG-Frameworks beruht auf seinen drei Hauptkomponenten, die alle auf fortschrittlichen neuronalen Netzwerkarchitekturen basieren: dem Retriever, dem Ranker und dem Generator. Diese Komponenten arbeiten nahtlos zusammen, um kontextuell relevante, präzise und informative Antworten bereitzustellen.

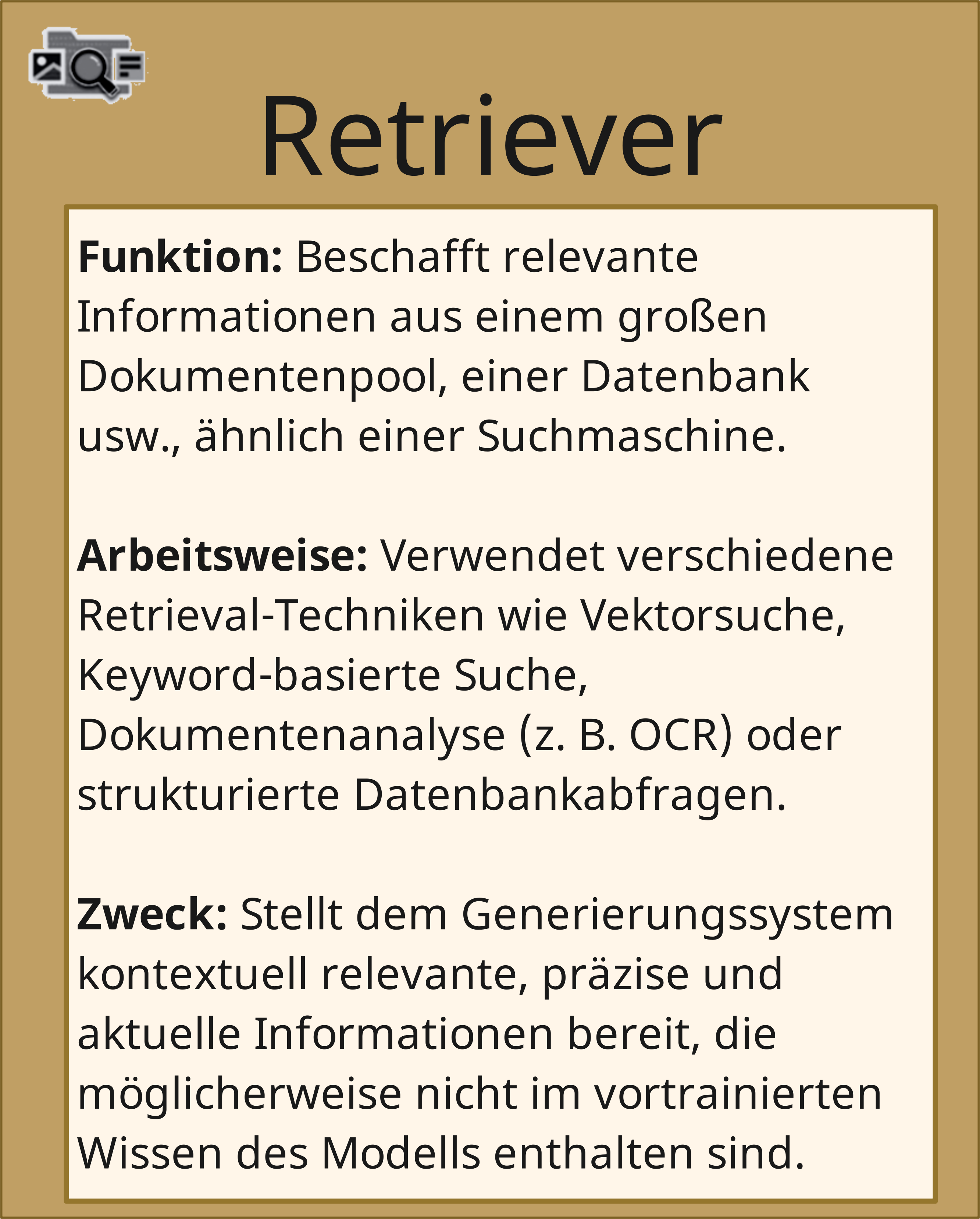

1. Der Retriever: Der blitzschnelle Bibliothekar

Unser digitaler Bibliothekar läuft nicht durch physische Regale – er navigiert mit unglaublicher Geschwindigkeit durch riesige Datenbanken. Wenn Sie eine Frage stellen, dann:

Unser digitaler Bibliothekar läuft nicht durch physische Regale – er navigiert mit unglaublicher Geschwindigkeit durch riesige Datenbanken. Wenn Sie eine Frage stellen, dann:

- durchsucht er digitale "Regale" mithilfe von Vektorsuche (ähnlich dem Auffinden von Büchern mit ähnlichen Themen)

- verwendet Keyword-Matching (ähnlich wie das Durchsuchen von Buchindizes, aber sofortig)

- stellt Anfragen an strukturierte Datenbanken (wie das Konsultieren eines perfekt organisierten Karteikatalogs)

- nutzt semantische Suche (versteht, wonach Sie suchen, selbst wenn Sie andere Worte verwenden)

Dieser digitale Bibliothekar durchsucht nicht nur Titel – er scannt ganze Dokumente in Millisekunden, um relevante Informationen zu finden, die tief im Text verborgen sein könnten. Seine Hauptaufgabe besteht darin, große Datenmengen, sowohl strukturiert als auch unstrukturiert, zu durchsuchen, um Inhalte zu finden, die für die gestellte Anfrage relevant sind.

Wenn ein Benutzer eine Anfrage einreicht, verwendet der Retriever verschiedene Techniken, um potenziell nützliche Informationen zu sammeln:

- Vektorsuche: Der Retriever stellt sowohl die Anfrage als auch die Dokumente in der Datenbank als hochdimensionale Vektoren dar und verwendet dann Cosinus-Ähnlichkeit oder andere Distanzmetriken, um Dokumente mit Vektoren zu finden, die dem Abfragevektor am ähnlichsten sind.

- Keyword-basierte Suche: Der Retriever sucht nach genauen Übereinstimmungen oder Variationen der Schlüsselwörter aus der Abfrage im Dokumentenkorpus.

- Anfragen an strukturierte Datenbanken: Wenn die Informationen in einem strukturierten Format wie einer relationalen Datenbank gespeichert sind, kann der Retriever SQL oder ähnliche Abfragesprachen verwenden, um relevante Daten abzurufen.

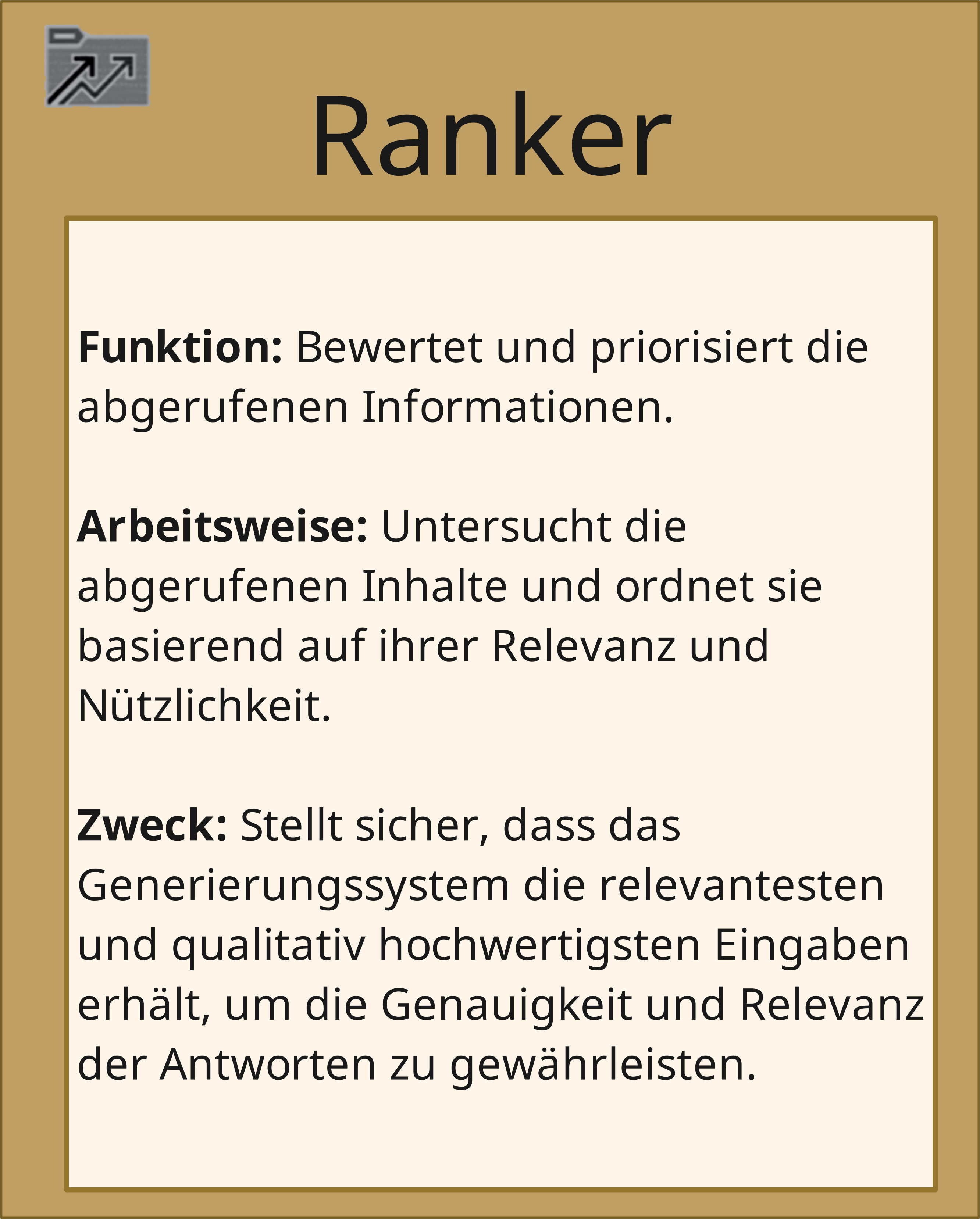

2. Der Ranker: Der Experte am Informationsschalter

Nachdem der Retriever potenziell relevante Informationen gesammelt hat, übernimmt der Ranker die Rolle eines erfahrenen Informationsspezialisten, der jede Quelle bewertet. Der Ranker verwendet verschiedene Algorithmen, um die Relevanz und Nützlichkeit jeder gefundenen Information für die gegebene Anfrage zu bestimmen. Einige der vom Ranker berücksichtigten Faktoren sind:

Nachdem der Retriever potenziell relevante Informationen gesammelt hat, übernimmt der Ranker die Rolle eines erfahrenen Informationsspezialisten, der jede Quelle bewertet. Der Ranker verwendet verschiedene Algorithmen, um die Relevanz und Nützlichkeit jeder gefundenen Information für die gegebene Anfrage zu bestimmen. Einige der vom Ranker berücksichtigten Faktoren sind:

- Wie relevant ist diese Information? Wie gut passt sie zur Intention und zum Kontext der Benutzerfrage?

- Wie zuverlässig ist diese Quelle?

- Ist die Information aktuell?

- Wie gut erklärt diese Information, was wir wissen müssen?

- Gibt es Widersprüche oder Lücken zwischen den Quellen, die gefüllt werden müssen?

Ähnlich wie ein guter Informationsspezialist, der weiß, welche Quellen Priorität haben, stellt der Ranker sicher, dass nur die wertvollsten Informationen weiterverarbeitet werden. Sobald der Retriever eine Sammlung potenziell relevanter Dokumente zusammengetragen hat, bewertet und priorisiert der Ranker diese Informationen aus verschiedenen Pools, Unternehmensdatenbanken und anderen Quellen.

Durch die effektive Rangfolge der gesammelten Informationen stellt der Ranker sicher, dass der Generator nur die relevantesten und qualitativ hochwertigsten Eingaben erhält. Dieser Schritt ist entscheidend, um die Genauigkeit und Relevanz der finalen Antwort zu gewährleisten.

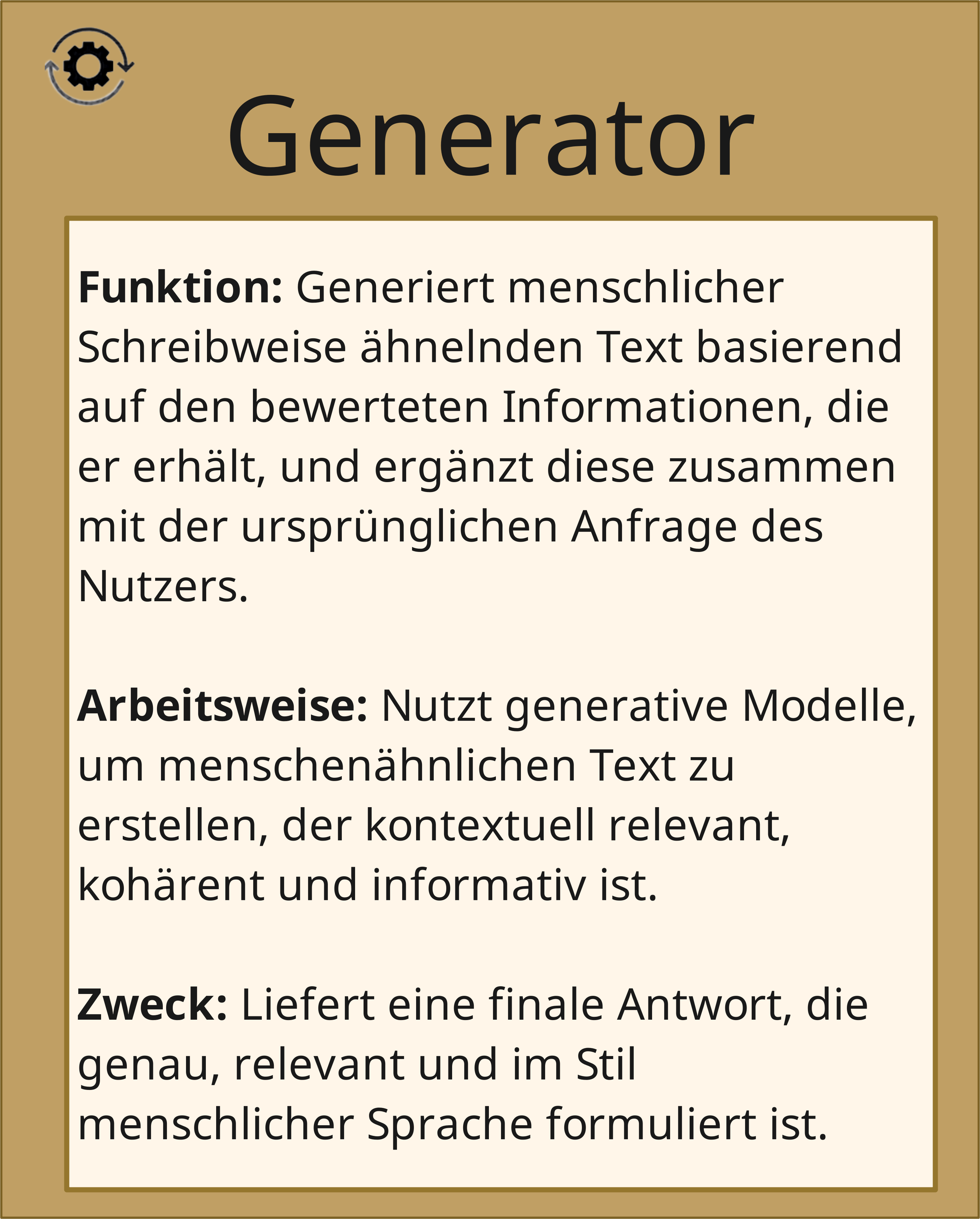

3. Der Generator: Der Synthetisierer der Forschung

Der Generator kann als geschickter Forschungsassistent betrachtet werden, der alle sorgfältig ausgewählten Materialien zu einer klaren, umfassenden Antwort zusammenfügt. Als abschließende Komponente des RAG-Frameworks ist er entscheidend für die Aufrechterhaltung der Genauigkeit und Relevanz der finalen Antwort. Der Generator:

Der Generator kann als geschickter Forschungsassistent betrachtet werden, der alle sorgfältig ausgewählten Materialien zu einer klaren, umfassenden Antwort zusammenfügt. Als abschließende Komponente des RAG-Frameworks ist er entscheidend für die Aufrechterhaltung der Genauigkeit und Relevanz der finalen Antwort. Der Generator:

- kombiniert Informationen aus mehreren Quellen nahtlos

- sorgt für Konsistenz innerhalb der Erklärung

- stellt technische Details korrekt dar

- formatiert die Informationen angemessen für die Anfrage

- löst Widersprüche zwischen verschiedenen Quellen

Der Generator basiert typischerweise auf einem Sequence-to-Sequence (Seq2Seq)-Modell, einer Art von neuronaler Netzwerkarchitektur, die Ausgabesequenzen basierend auf Eingabesequenzen generieren kann. Im Kontext von RAG ist die Eingabesequenz die Benutzeranfrage zusammen mit den am höchsten bewerteten abgerufenen Informationen, und die Ausgabesequenz ist die generierte Antwort.

Seq2Seq-Modelle bestehen aus zwei Hauptkomponenten:

- Encoder: Der Encoder verarbeitet die Eingabesequenz (Anfrage + abgerufene Informationen) und wandelt sie in eine feste Vektordarstellung um, die die wesentlichen Informationen enthält. Das ist vergleichbar mit einem Forscher, der die ausgewählten Quellen liest und sich die wichtigsten Punkte merkt.

- Decoder: Der Decoder nimmt die kodierte Darstellung und generiert die Ausgabesequenz (Antwort) Token für Token, basierend auf der Eingabe und seinen eigenen vorherigen Ausgaben. Das ist vergleichbar mit einem Forscher, der basierend auf seinem Verständnis der Anfrage und den relevanten Informationen eine Antwort formuliert.

Der Generator nutzt die Stärke von Seq2Seq-Modellen, um menschlich wirkende Antworten zu erstellen, die nicht nur sachlich korrekt und relevant, sondern auch kohärent, flüssig und stilistisch typisch für die menschliche Sprache sind. Er sorgt dafür, dass die endgültige Antwort die abgerufenen Informationen nahtlos in einen natürlichen, konversationsähnlichen Fluss integriert.

RAG in Aktion: Ein Bibliotheksvergleich

Um besser zu verstehen, wie das RAG-Framework funktioniert, kehren wir zu unserem Bibliotheksvergleich zurück und sehen uns an, wie die Komponenten Retriever, Ranker und Generator den Rollen des Bibliothekspersonals entsprechen. Wie eine gut funktionierende Bibliothek auf die nahtlose Zusammenarbeit von Bibliothekaren, Informationsspezialisten und Forschungsassistenten angewiesen ist, beruht die Effektivität des RAG-Frameworks auf dem harmonischen Zusammenspiel der Komponenten Retriever, Ranker und Generator.

Um besser zu verstehen, wie das RAG-Framework funktioniert, kehren wir zu unserem Bibliotheksvergleich zurück und sehen uns an, wie die Komponenten Retriever, Ranker und Generator den Rollen des Bibliothekspersonals entsprechen. Wie eine gut funktionierende Bibliothek auf die nahtlose Zusammenarbeit von Bibliothekaren, Informationsspezialisten und Forschungsassistenten angewiesen ist, beruht die Effektivität des RAG-Frameworks auf dem harmonischen Zusammenspiel der Komponenten Retriever, Ranker und Generator.

Wenn jemand mit einer Frage in unsere digitale Bibliothek kommt, passiert Folgendes:

1. Verarbeitung der initialen Anfrage

Wenn ein Nutzer eine Frage stellt, verarbeitet das System diese zuerst. Genauso wie ein Bibliothekar klärende Fragen stellen könnte, analysiert das System, wonach wirklich gesucht wird. Dabei berücksichtigt es auch den Kontext früherer Gespräche (wie ein Bibliothekar, der sich an das Forschungsthema des letzten Besuchs erinnert).

2. Der Suchprozess

Der Retriever ist wie ein schnell arbeitender Bibliothekar, der die Sammlung der Bibliothek in- und auswendig kennt. Ähnlich wie der Bibliothekar navigiert der Retriever schnell durch die Regale, Datenbanken und Kataloge, um alle Bücher, Artikel und anderen Ressourcen zu sammeln, die relevante Informationen enthalten könnten.

Der Retriever durchsucht die digitalen Sammlungen (die nicht nur Dokumentenpools, sondern auch relationale Datenbanken eines Unternehmens und andere Medien umfassen). Dabei können mehrere Suchstrategien gleichzeitig verwendet werden. Relevante Materialien werden schnell gesammelt und Informationen zu den Quellen vermerkt.

Schließlich kehrt der Bibliothekar aus den Archiven mit einer umfangreichen Sammlung von Materialien zurück, und nun muss entschieden werden, welche der enthaltenen Informationen wirklich von Bedeutung sind.

3. Bewertung und Auswahl

Der Ranker ist wie der Experte am Informationsschalter, der den Stapel der Materialien vom Bibliothekar bewertet. Er berücksichtigt Faktoren wie das Veröffentlichungsdatum, die Autorität des Autors und wie gut der Inhalt den Bedürfnissen des Nutzers entspricht. Die Materialien werden basierend auf ihrer Relevanz und Qualität sortiert, wobei die nützlichsten Quellen priorisiert werden.

Zu diesem Zweck bewertet der Ranker alle abgerufenen Materialien und priorisiert alle Quellen basierend auf der Relevanz der Inhalte und der Zuverlässigkeit der Quelle. Doppelte Informationen werden konsolidiert, und schließlich werden die wertvollsten Quellen ausgewählt.

4. Erstellung der Antwort

Der Generator ist wie ein erfahrener Forschungsassistent, der den kuratierten Stapel von Materialien nimmt und die Informationen zu einer umfassenden, gut strukturierten Antwort zusammenfügt. Er weiß, wie man Schlüsselpunkte extrahiert, Ideen aus verschiedenen Quellen verbindet und die Informationen klar und ansprechend präsentiert. Er sorgt dafür, dass das Endprodukt nicht nur eine Sammlung von Fakten ist, sondern eine kohärente, kontextuell angemessene Antwort auf die Frage des Nutzers.

Um dies zu erreichen, werden alle vom Ranker ausgewählten Informationen organisiert. Anschließend wird eine kohärente Antwort erstellt. Im nächsten Schritt wird die Antwort erneut mit den Quellen abgeglichen. Wenn sie genehmigt ist, wird die endgültige Antwort dem Kunden präsentiert.

Warum dieses digitale Bibliothekssystem wichtig ist

Das RAG-Framework bringt mehrere bedeutende Vorteile in den Bereich der Sprachmodelle:

Das RAG-Framework bringt mehrere bedeutende Vorteile in den Bereich der Sprachmodelle:

- Erweiterbarkeit: Durch die Entkopplung des Wissensabrufprozesses vom vortrainierten Sprachmodell ermöglicht RAG die einfache Integration neuer, aktueller Informationen. Die Sammlung kann kontinuierlich erweitert werden, und neue Inhalte können jederzeit hinzugefügt werden; ein LLM müsste jedes Mal neu trainiert werden, wenn neue Inhalte hinzukommen, was zu Wissenssperren zu bestimmten Zeitpunkten führt. Mit RAG basieren die Antworten auf tatsächlichen Quellen anstatt nur auf „Gedächtnis“, und die Bibliothek kann aktualisiert werden, ohne das gesamte System neu aufzubauen.

- Spezialisierung: RAG-Modelle können auf spezifische Fachgebiete oder Anwendungsfälle zugeschnitten werden, indem der Dokumentenkorpus, aus dem sie Informationen beziehen, kuratiert wird. Dies ermöglicht die Erstellung leistungsstarker, domänenspezifischer Frage-Antwort-Systeme.

- Nachvollziehbarkeit: Das RAG-Framework bietet eine klare Spur der Informationen, die zur Erstellung einer Antwort verwendet wurden. Jede Information kann bis zu ihrer Quelle zurückverfolgt werden. Diese Transparenz kann in Anwendungen entscheidend sein, bei denen die Herkunft der Informationen wichtig ist, beispielsweise im medizinischen oder rechtlichen Kontext.

- Effizienz: Durch die Kombination von Retrieval-Techniken und Ranking-Algorithmen kann RAG riesige Informationsmengen schnell durchsuchen und sich auf die relevantesten Teile konzentrieren, wodurch die Rechenlast für den Generator reduziert wird.

Reale Anwendungsfälle

Ähnlich wie Bibliotheken viele Zwecke erfüllen, sind auch RAG-Systeme vielseitig einsetzbar:

- Technische Dokumentationssysteme, die stets mit den neuesten Updates aktuell bleiben

- Kundendienstsysteme, die auf Unternehmensrichtlinien zugreifen und diese verstehen können

- Forschungswerkzeuge, die Informationen aus mehreren Quellen finden und zusammenfassen können

- Bildungssysteme, die genaue, gut fundierte Erklärungen liefern

RAG verwandelt KI von einem System, das einfach Informationen speichert, in eines, das aktiv recherchieren, bewerten und präsentieren kann – ähnlich wie ein Weltklasse-Bibliothekssystem, jedoch in digitaler Geschwindigkeit. Während wir in den folgenden Teilen dieser Artikelserie die Feinheiten von RAG weiter erkunden, behalten Sie dieses grundlegende Framework und die Zusammenarbeit seiner Komponenten im Hinterkopf, die ein System schaffen, das nicht nur ein Speicher statischen Wissens, sondern ein aktiver, dynamischer Teilnehmer bei der Suche nach Verständnis ist.